El Emperador Desnudo de Silicon Valley

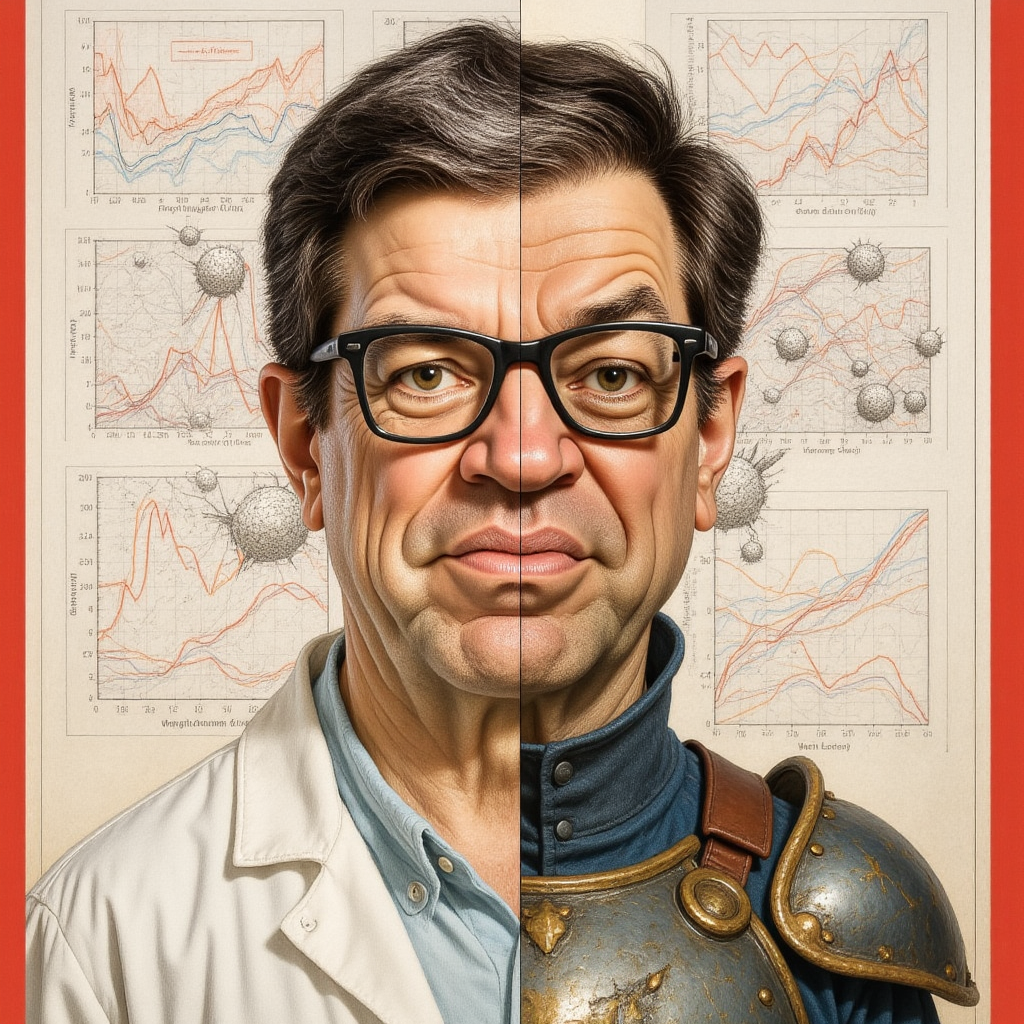

Imaginen por un momento que uno de los arquitectos fundamentales de la era digital moderna se levanta en plena euforia tecnológica y declara que el emperador va desnudo. Eso es, esencialmente, lo que ha hecho Yann LeCun, científico jefe de inteligencia artificial en Meta y uno de los tres «Padrinos de la Inteligencia Artificial» galardonados con el Premio Turing. Su veredicto sobre los Grandes Modelos de Lenguaje no es una crítica menor: los considera un «callejón sin salida» hacia la verdadera inteligencia artificial.

La bomba intelectual que ha detonado LeCun no es fruto de un arrebato mediático, sino de décadas de investigación en el campo. Sus trabajos pioneros en Redes Neuronales Convolucionales durante los años ochenta y noventa sentaron las bases de prácticamente toda la visión por computadora moderna. Cuando una figura de este calibre sugiere que la búsqueda de la inteligencia artificial de nivel humano a través del simple escalamiento de los LLM es fundamentalmente errónea, la industria se ve obligada a reconsiderar inversiones que rondan los dos billones de dólares.

El argumento central de LeCun trasciende las disputas técnicas habituales y toca el núcleo filosófico de qué constituye realmente la inteligencia. Su mensaje es directo y provocador: los sistemas actuales, por muy elocuentes que sean, carecen de algo fundamental que todo niño de cuatro años posee naturalmente: una comprensión auténtica del mundo físico.

La Paradoja de la Dieta Informacional

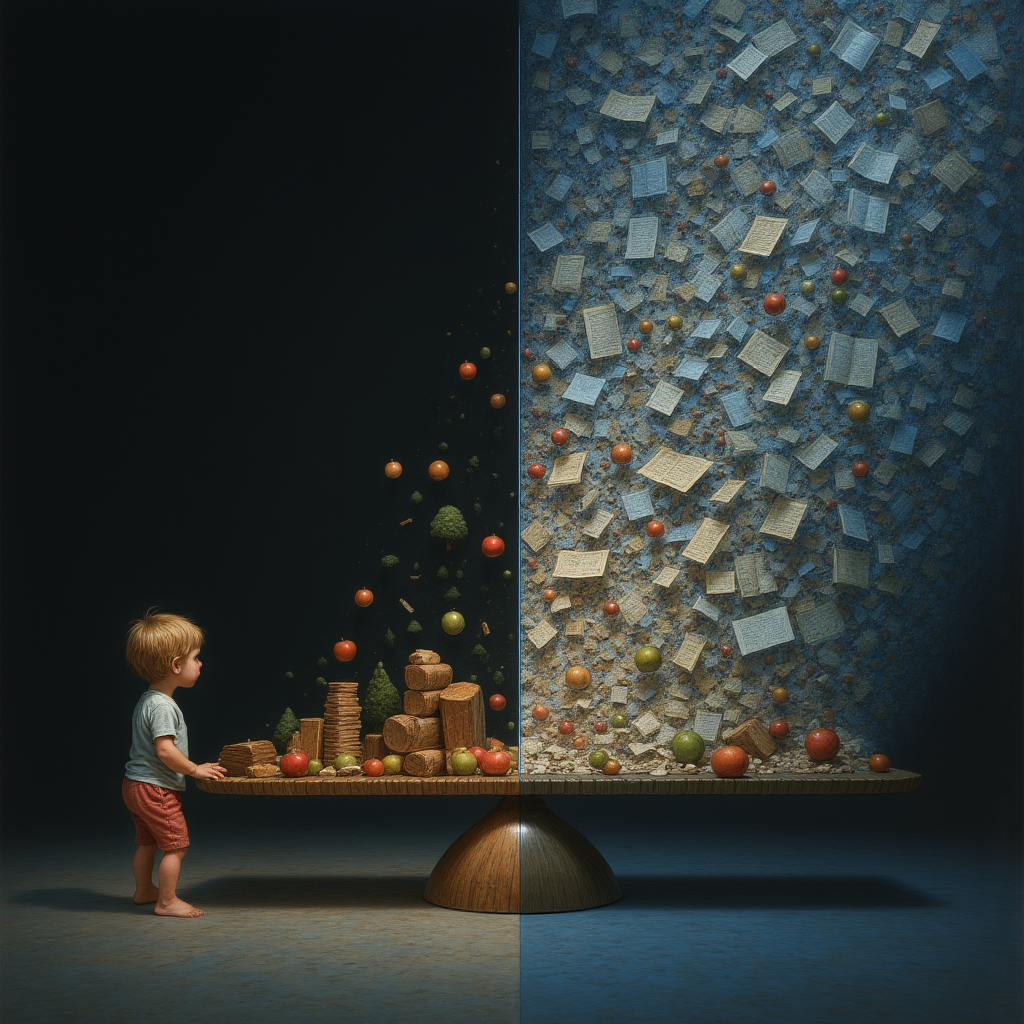

El argumento más contundente de LeCun reside en una comparación que, a primera vista, parece favorecer abrumadoramente a las máquinas, pero que al examinarla en profundidad revela una paradoja devastadora. Un LLM de última generación se entrena con un corpus textual que podría requerir que un ser humano dedicara 170,000 años de lectura ininterrumpida.

Esta cifra astronómica representa aproximadamente 2×1013 bytes de información procesada.

Sin embargo, LeCun invierte magistralmente la perspectiva: un niño de cuatro años, en sus escasas 16,000 horas de vigilia, procesa a través de su nervio óptico una cantidad de datos visuales estimada en 1015 bytes, una cifra cincuenta veces superior al corpus textual más masivo. La implicación es profunda: el lenguaje es un medio de baja dimensionalidad, una «versión serializada de nuestros pensamientos», no el pensamiento mismo.

Esta «dieta de datos» revela una eficiencia de aprendizaje abismal en los LLM. Mientras un infante aprende que los objetos caen con uno o dos ejemplos directos, un modelo de lenguaje necesita procesar miles de descripciones textuales sobre la gravedad sin desarrollar jamás una comprensión visceral del concepto.

La diferencia no es meramente cuantitativa sino cualitativa: estamos comparando conocimiento de experiencia con información estadística.

La crítica de LeCun expone una verdad incómoda que la industria ha preferido ignorar: los LLM están privados de la fuente de información más rica que existe, el mundo real, y ninguna cantidad de texto adicional puede compensar esta carencia fundamental.

JEPA: La Arquitectura de la Comprensión

Frente a lo que considera un paradigma defectuoso, LeCun no se limita a la crítica destructiva, sino que propone una alternativa radical: la Arquitectura Predictiva de Incrustación Conjunta, conocida como JEPA (Joint Embedding Predictive Architecture). Esta propuesta representa un cambio conceptual tan profundo como el que supuso el paso de los sistemas expertos a las redes neuronales en los años noventa.

JEPA opera bajo un principio fundamentalmente distinto al de los modelos generativos. Mientras un LLM intenta predecir cada palabra siguiente con precisión obsesiva, JEPA predice en un «espacio de representación abstracto» de menor dimensionalidad. La diferencia es análoga a la que existe entre un estudiante que memoriza respuestas específicas y otro que comprende los principios subyacentes para generalizar.

Los resultados experimentales de V-JEPA han sido verdaderamente reveladores. En pruebas inspiradas en la psicología del desarrollo infantil, el modelo demostró capacidad para distinguir entre eventos físicamente posibles e imposibles con una precisión del 98% en el «benchmark IntPhys», sin haber sido entrenado específicamente para esta tarea. Más significativo aún: en las mismas pruebas, los LLM multimodales de última generación tuvieron un rendimiento cercano al azar.

Esta evidencia empírica sugiere que JEPA, al aprender representaciones abstractas del mundo, adquiere una comprensión más profunda de la realidad que los enfoques generativos. V-JEPA 2.0, con 1.2 mil millones de parámetros, ya demuestra capacidades de planificación robótica en entornos no vistos, acercando esta visión teórica a aplicaciones prácticas tangibles.

El Tablero Comercial: Más Allá de la Ciencia Pura

Sería ingenuo analizar esta controversia exclusivamente desde una perspectiva técnica, ignorando las fuerzas comerciales y estratégicas que la atraviesan. Meta invierte entre 60 y 65 mil millones de dólares en infraestructura de IA para 2025, construyendo centros de datos «suficientemente grandes para cubrir una parte significativa de Manhattan». Su estrategia dual combina el desarrollo de modelos Llama de código abierto con investigación fundamental en JEPA.

Esta aparente contradicción, LeCun critica los LLM mientras Meta desarrolla Llama, revela una sofisticación estratégica notable. LeCun prevé un rol específico para los LLM en el futuro: no como núcleo de la inteligencia, sino como «interfaz de lenguaje» que traduce los razonamientos abstractos de un modelo de mundo subyacente a comunicación comprensible para humanos.

Las reacciones de la industria han sido reveladoras. Sam Altman de OpenAI mantiene un optimismo agresivo sobre la Inteligencia General Artificial, mientras que Hassabis de Google DeepMind confronta directamente las afirmaciones de LeCun. Particularmente explosiva ha sido la disputa con Dario Amodei de Anthropic, a quien LeCun acusa de «deshonestidad intelectual» por advertir sobre peligros de AGI mientras desarrolla esos mismos sistemas.

Estas tensiones trascienden desacuerdos académicos y reflejan una batalla existencial por el control de la próxima fase de la evolución tecnológica, con valoraciones empresariales que podrían sufrir reevaluaciones masivas si las arquitecturas fundamentales son cuestionadas exitosamente.

Análisis Crítico: Limitaciones y Contraargumentos

La credibilidad de LeCun, aunque substancial, no está exenta de vulnerabilidades. Sus predicciones sobre las capacidades a corto plazo de los LLM han resultado repetidamente incorrectas. A medida que los modelos han superado barreras que él mismo establecía, ha ajustado sus afirmaciones sin abandonar su tesis central, erosionando parcialmente su autoridad predictiva en este debate específico.

El sesgo institucional es evidente pero no necesariamente descalificador. LeCun dirige FAIR de Meta, que invierte masivamente en JEPA como alternativa a LLM, mientras la empresa compite directamente con OpenAI y Google. Esta paradoja de criticar LLM mientras desarrolla Llama sugiere conflictos de interés que deben considerarse al evaluar sus afirmaciones.

Más fundamentalmente, existe la posibilidad de que LeCun esté subestimando algunas capacidades emergentes de estos modelos. Estudios recientes de 2024 han documentado casos sorprendentes en los que las inteligencias artificiales resuelven tareas sin haber visto nunca ejemplos previos (lo que se conoce como «zero-shot»), mostrando razonamientos complejos y comprensión contextual que van mucho más allá de repetir patrones como un loro. Por ejemplo, GPT-4 supera a médicos humanos en algunas pruebas de diagnóstico, y sus habilidades de programación compiten con las de desarrolladores con experiencia.

El cronograma de adopción de Modelos de Mundo que LeCun propone, obsolescencia de LLM en 3-5 años, parece agresivamente optimista considerando los desafíos técnicos y comerciales de implementar sistemas híbridos a gran escala.

El Futuro Híbrido: Síntesis y Perspectivas

El escenario más probable no es la victoria absoluta de ningún paradigma, sino una evolución gradual hacia sistemas híbridos que combinen las fortalezas complementarias de ambos enfoques. Los LLM han demostrado ser interfaces de lenguaje natural excepcionalmente potentes, mientras que los Modelos de Mundo prometen capacidades de comprensión física y planificación que los sistemas puramente textuales nunca podrán alcanzar.

Esta convergencia tecnológica desbloqueará casos de uso transformadores: robots con comprensión semántica del entorno, gemelos digitales que simulan sistemas complejos con precisión predictiva, y asistentes de IA capaces de razonamiento multimodal genuino. El futuro de la inteligencia artificial no será monolítico sino un ecosistema especializado donde diferentes arquitecturas resuelvan problemas específicos.

Para las empresas, esto implica estrategias de protección frente a la incertidumbre (hedging) más sofisticadas: diversificar su tecnología usando distintas arquitecturas, desarrollar capacidades en Modelos de Mundo, y mantener flexible su stack tecnológico. Los inversores deberían reducir exposición a empresas dependientes exclusivamente de LLM y diversificar hacia infraestructura computacional y aplicaciones físicas.

La revolución silenciosa de LeCun representa algo más profundo que una disputa técnica: es la evolución conceptual de IA basada en patrones estadísticos hacia IA con comprensión causal del mundo físico. Este debate continuará intensificándose conforme V-JEPA y arquitecturas similares demuestren capacidades prácticas, pero lo que está en juego trasciende preferencias tecnológicas y define el camino hacia la inteligencia artificial de nivel humano.

🧩 ¿ENTIENDES EL JUEGO O SOLO VES LA PANTALLA?

La inteligencia no siempre habla en voz alta. A veces pregunta en silencio.

¿Tiene sentido seguir alimentando modelos que no entienden el mundo que describen?

¿Crees que comprender va más allá de predecir palabras?

No buscamos consenso, buscamos conversación. Tu perspectiva cuenta, sobre todo si desafía la corriente.

JL Meana — TecnoTimes

Divulgación científica con honestidad. Sin obediencia ideológica. Sin cuentos.

“Neutralidad no es objetividad y propaganda no es periodismo.”

Muy interesante, Meana.

Super interesante !